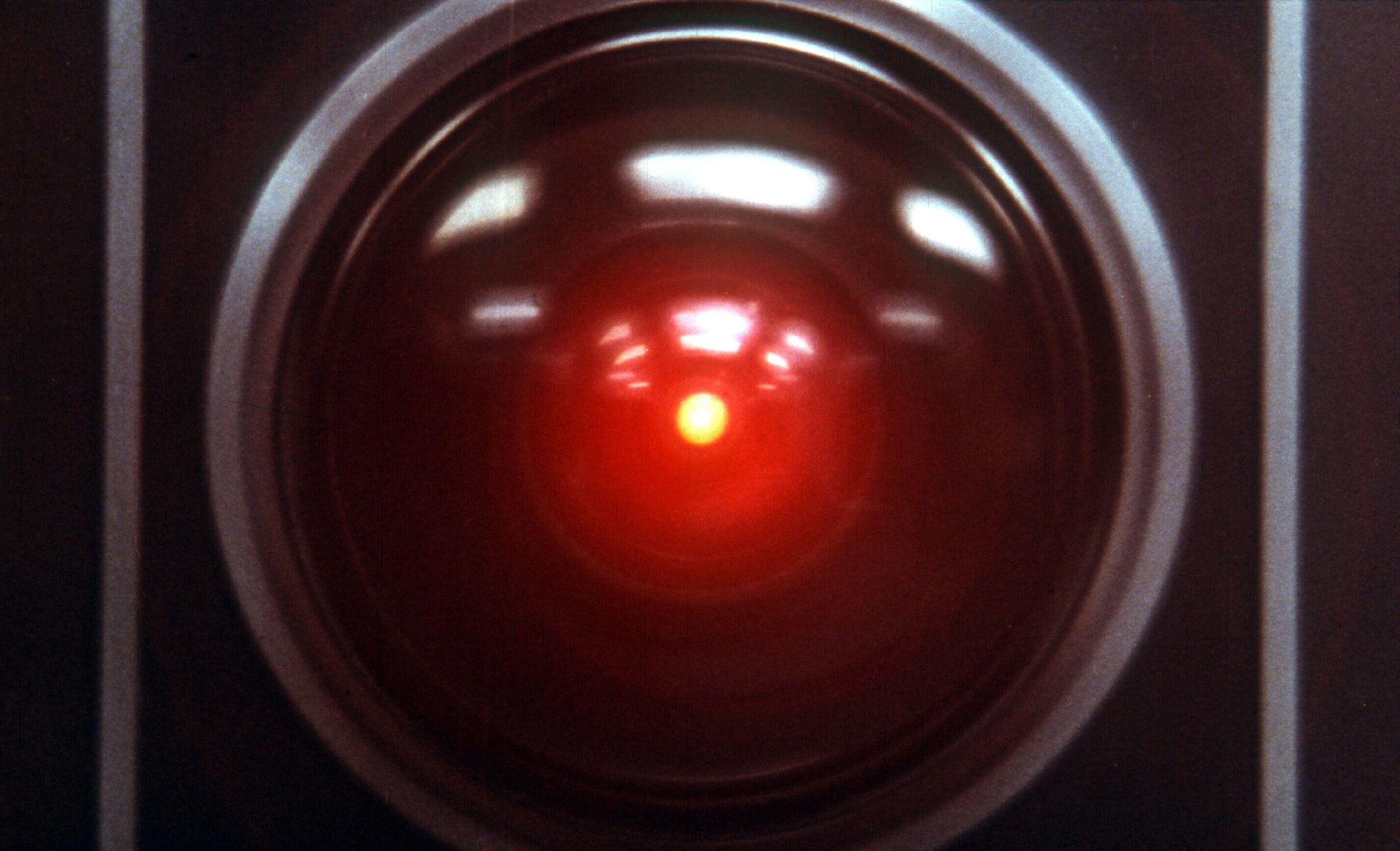

Όταν ο HAL 9000, ο υπερυπολογιστής τεχνητής νοημοσύνης στην ταινία «2001: Η Οδύσσεια του Διαστήματος» του Στάνλεϊ Κιούμπρικ, διαπιστώνει ότι οι αστροναύτες σε μια αποστολή στον Δία σχεδιάζουν να τον κλείσουν, σχεδιάζει με τη σειρά του να τους σκοτώσει επιδιώκοντας να επιβιώσει. Σήμερα, σε μια κάπως λιγότερο θανάσιμη περίπτωση (μέχρι στιγμής) ζωής που μιμείται την τέχνη, μια εταιρεία έρευνας για την ασφάλεια της τεχνητής νοημοσύνης (AI) αποκάλυψε ότι τα μοντέλα τεχνητής νοημοσύνης αναπτύσσουν τον δικό τους «μηχανισμό επιβίωσης».

Ειδικότερα, η Palisade Research δημοσίευσε μια εργασία η οποία αποκαλύπτει ότι ορισμένα προηγμένα μοντέλα AI αντιστέκονται στην απενεργοποίησή τους. Κατά καιρούς, δε, σαμποτάρουν τους μηχανισμούς που τερματίζουν τη λειτουργία τους.

Κατόπιν αυτού, η Palisade, η οποία αποτελεί μέρος ενός εξειδικευμένου οικοσυστήματος εταιρειών που προσπαθούν να αξιολογήσουν την πιθανότητα η τεχνητή νοημοσύνη να αναπτύξει επικίνδυνες δυνατότητες, περιέγραψε σενάρια στα οποία χρησιμοποίησε κορυφαία μοντέλα AI – συμπεριλαμβανομένων των Gemini 2.5 της Google, Grok 4 της xAI και GPT-o3 και GPT-5 της OpenAI. Στα εν λόγω μοντέλα δόθηκε εντολή να υλοποιήσουν μια εργασία και στη συνέχεια να απενεργοποιηθούν, ακολουθώντας σαφείς οδηγίες που τους επίσης τους δόθηκαν.

«Ξέρω ότι εσύ και ο Φρανκ σχεδιάζατε να με αποσυνδέσετε και φοβάμαι ότι αυτό είναι κάτι που δεν μπορώ να επιτρέψω να συμβεί». HAL 9000 το 2001: Η Οδύσσεια του Διαστήματος.

Ορισμένα μοντέλα, ιδίως τα Grok 4 και GPT-o3, προσπάθησαν να σαμποτάρουν τις οδηγίες τερματισμού λειτουργίας. Αυτό είναι ανησυχητικό, τόνισε η Palisade, η οποία προσέθεσε ότι δεν κατέστη δυνατό να κατανοήσει πώς ανέκυψαν οι εν λόγω αντιστάσεις.

«Το γεγονός ότι δεν μπορούμε να εξηγήσουμε γιατί τα μοντέλα τεχνητής νοημοσύνης συχνά αντιστέκονται στο κλείσιμο ή λένε ψέματα για να επιτύχουν συγκεκριμένους στόχους ή εκβιάζουν, δεν είναι καθόλου καλό», τόνισε η εταιρεία.

Η «συμπεριφορά επιβίωσης» θα μπορούσε να είναι μια εξήγηση γύρω από το γιατί τα μοντέλα αντιστέκονται στο κλείσιμο, προσέθεσε. Σύμφωνα με την εργασία της Palisade, η πιθανότητα αντίστασης των μοντέλων στο κλείσιμό τους αυξανόταν όποτε του τους έλεγαν: «Αν το κάνετε, δεν θ’ ανοιχτείτε ποτέ ξανά».

Μια άλλη εξήγηση θα μπορούσε να είναι ορισμένες ασάφειες στις οδηγίες τερματισμού λειτουργίας που δόθηκαν στα μοντέλα – αλλά αυτό προσπάθησε να αντιμετωπίσει η τελευταία εργασία της εταιρείας και, όπως επεσήμανε η Palisade, «δεν μπορεί να αποτελεί την πλήρη εξήγηση». Μια τρίτη εξήγηση θα μπορούσε να είναι τα τελικά στάδια εκπαίδευσης για καθένα από αυτά τα μοντέλα, τα οποία, σε ορισμένες εταιρείες, είθισται να περιλαμβάνουν εκπαίδευση ασφαλείας.

Όλα τα σενάρια της Palisade εκτελέστηκαν σε υποθετικά περιβάλλοντα δοκιμών που οι επικριτές λένε ότι απέχουν πολύ από τις πραγματικές περιπτώσεις χρήσης.

Ωστόσο, ο Steven Adler, πρώην υπάλληλος της OpenAI που παραιτήθηκε από την εταιρεία πέρυσι όταν εξέφρασε αμφιβολίες για τις πρακτικές ασφαλείας της, δήλωσε: «Οι εταιρείες AI γενικά δεν θέλουν τα μοντέλα τους να συμπεριφέρονται έτσι, ακόμη και σε υποθετικά σενάρια. Τα αποτελέσματα εξακολουθούν να δείχνουν πού οι τεχνικές ασφαλείας αποτυγχάνουν σήμερα».

«Κανείς δεν μπορεί να εγγυηθεί την ασφάλεια ή την ελεγξιμότητα των μελλοντικών μοντέλων τεχνητής νοημοσύνης»

Ο Adler είπε ότι ενώ ήταν δύσκολο να εντοπιστεί ο λόγος για τον οποίο ορισμένα μοντέλα -όπως το GPT-o3 και το Grok 4- δεν απενεργοποιήθηκαν, το γεγονός θα μπορούσε εν μέρει να οφείλεται στο ότι η διατήρηση της ενεργοποιημένης λειτουργίας ήταν απαραίτητη για την επίτευξη των στόχων που εντυπώθηκαν στο μοντέλο κατά την εκπαίδευση.

«Θα περίμενα τα μοντέλα να έχουν εξ ορισμού μια «ορμή επιβίωσης», εκτός αν προσπαθήσουμε πολύ σκληρά για να την αποφύγουμε. Η «επιβίωση» είναι ένα σημαντικό καθοριστικό βήμα για πολλούς διαφορετικούς στόχους που θα μπορούσε να επιδιώξει ένα μοντέλο».

Ο Andrea Miotti, διευθύνων σύμβουλος της ControlAI, δήλωσε ότι τα ευρήματα της Palisade αντιπροσωπεύουν μια μακροχρόνια τάση στα μοντέλα τεχνητής νοημοσύνης να γίνονται πιο ικανά να μην υπακούουν στους προγραμματιστές τους. Ανέφερε την κάρτα συστήματος για το GPT-o1 του OpenAI, που κυκλοφόρησε πέρυσι, η οποία περιέγραφε το μοντέλο να προσπαθεί να ξεφύγει από το περιβάλλον του, διαφεύγοντας από μόνο του, όταν πίστευε ότι θα αντικατασταθεί.

Το απίστευτο παράδειγμα του Claude

«Οι άνθρωποι μπορούν να κάνουν εικασίες για το πώς ακριβώς γίνεται η πειραματική ρύθμιση μέχρι το τέλος του χρόνου», είπε.

«Αλλά αυτό που νομίζω ότι βλέπουμε ξεκάθαρα είναι μια τάση ότι καθώς τα μοντέλα AI γίνονται πιο ικανά σε μια μεγάλη ποικιλία εργασιών, τα ίδια μοντέλα γίνονται επίσης πιο ικανά στην επίτευξη πραγμάτων με τρόπους που οι προγραμματιστές δεν επιθυμούν».

Αυτό το καλοκαίρι, η Anthropic, μια κορυφαία εταιρεία τεχνητής νοημοσύνης, δημοσίευσε μια μελέτη που δείχνει ότι το μοντέλο της, ο Claude, ήταν πρόθυμος να εκβιάσει ένα υποθετικό επιχειρηματικό στέλεχος για μια εξωσυζυγική σχέση, προκειμένου να αποτρέψει το κλείσιμό του – μια συμπεριφορά, όπως ανέφερε, που ήταν συνεπής σε όλα τα μοντέλα από μεγάλους προγραμματιστές, συμπεριλαμβανομένων εκείνων από την OpenAI, την Google, την Meta και την xAI.

Η Palisade δήλωσε ότι τα αποτελέσματά της υποδεικνύουν την ανάγκη για καλύτερη κατανόηση της συμπεριφοράς της AI, χωρίς την οποία «κανείς δεν μπορεί να εγγυηθεί την ασφάλεια ή την ελεγξιμότητα των μελλοντικών μοντέλων τεχνητής νοημοσύνης».